Viel ist in den letzten Tagen geschrieben worden über Googles neustes Projekt namens Knols, das am 13. Dezember 2007 im offiziellen Google Blog angekündigt wurde. Und obwohl es sich um eine private Beta-Phase handelt und erst wenige von der Plattform mehr als einen gigantischen Screenshot gesehen haben, sind sich alle einig: Google will eine Konkurrenz zur Wikipedia lancieren. Das scheint mir ein bisschen arg verkürzt.

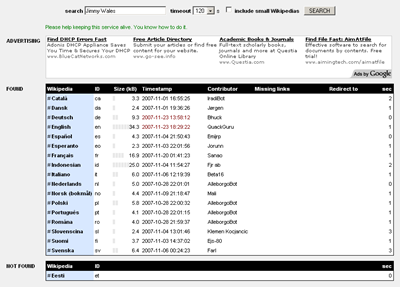

Halten wir fest: Google Knols ist eine Plattform, welche grundlegende Artikel (oder eben Knols = Units of Knowledge) zu Themen aus allen Wissensgebieten bereitstellen will. Dies ist zweifellos eine Parallele zur Wikipedia. Auch dass auf Knols grundsätzlich jeder publizieren kann, der möchte, erinnert an die freie Enzyklopädie. Es gibt aber auch einige wesentliche Unterschiede:

- Bei Google Knols wird jeder Artikel von einem einzigen Autor verfasst, und dieser wird prominent auf der entsprechenden Seite genannt. Bei der Wikipedia werden die Artikel in der Regel von vielen verschiedenen Personen geschrieben, deren Identität oft unklar und insgesamt unwichtig ist. Google Knols wird also Autoren anlocken, die sich als Spezialisten auf einem bestimmten Gebiet sehen und sich auf diesem Weg selbst vermarkten wollen. Den Wikipedianern dagegen geht es mehr um die Sache – jedenfalls kann man als Wikipedia-Autor kaum Berühmtheit ausserhalb der Community erlangen.

- Ziel der Wikipedia ist es, jedes Thema möglichst neutral und umfassend zu behandeln. Das ist ein hoher Anspruch und führt oft zu intensiven Auseinandersetzungen, bringt aber im Idealfall Artikel hervor, welche alle wesentlichen Positionen beleuchten. Bei Google Knols dagegen stellt ein Autor seinen eigenen Standpunkt dar – ist jemand anderer Meinung, so schreibt er nicht den Originalartikel um, sondern hinterlässt einen Kommentar oder verfasst eine Peer Review bzw. einen Konkurrenzartikel. Letzteres wiederum wäre in der Wikipedia undenkbar.

- Auch bei der Wikipedia gibt es Diskussionen, werden Beiträge anderer kommentiert und bewertet. All dies geschieht aber hinter den Kulissen – für den normalen Benutzer fühlt sich die Wikipedia wie eine normale Enzyklopädie an. Bei Google Knols dagegen gibt es viele klassische Web-2.0-Elemente: Kommentarfunktion, Rating, Peer Review, Related Content. Sie alle sollen mithelfen, relevanten Content an die Oberfläche zu spülen und zusammenhängende Informationen zu verbinden (bekanntlich eine Stärke von Google).

Google Knols konkurriert deshalb fast eher mit Blogs, Zeitungs- bzw. Zeitschriften-Websites und Wissensplattformen (z.B. www.akademie.de, www.wissen.de, www.about.com). Mit dem Versprechen, eine grosse Reichweite zu erzielen und zugleich die Autoren an den Werbeeinnahmen zu beteiligen, will Google publikationswillige Fachleute anlocken und so ohne eigene redaktionelle Leistung relevanten Content aufbauen. Dafür stellt Google die Plattform und die Hosting-Kapazität zur Verfügung:

«Writers only need to write; we’ll do the rest.»

Das ist smart. Knols dürfte eines der bedeutendsten Projekte sein, das Google je lanciert hat. Nicht nur die Wikipedia, sondern auch Medienhäuser und Verlage werden die neue Konkurrenz spüren. Und es stellt sich die Frage, ob hier nicht eine Grenze überschritten wird, die uns allen zu denken geben müsste: Google könnte schon bald nicht mehr nur die beherrschende Suchmaschine sein, sondern auch ein dominierender Content Provider. Ob dies der Informationsfreiheit, der Meinungsvielfalt und dem Wissensaustausch dient (wie Google das selbst gerne sieht), oder ob es einen weiteren Schritt in Richtung Informations-Monopol darstellt, muss sich erst noch weisen. Kritisch scheinen mir dabei folgende Punkte:

- Exklusivität – Google erhebt nach eigenen Aussagen keinen Exklusivitätsanspruch auf die Inhalte von Google Knols: «Google will not ask for any exclusivity on any of this content and will make that content available to any other search engine.» Was dies im Detail bedeutet, bedarf sicher noch der Klärung. Darf ein Autor einen Knols-Artikel auch in einer Zeitung oder in einem Buch veröffentlichen? Unterliegen die Artikel einer Creative Commons Licence oder gar der GDFL?

- Selektion der Autoren und inhaltliche Zensur – Nach heutigen Aussagen wird Google keinen Einfluss auf die Inhalte von Knols nehmen: «Google will not serve as an editor in any way, and will not bless any content. All editorial responsibilities and control will rest with the authors. […] Anyone will be free to write.» Bleibt es dabei, dann kann Google Knols tatsächlich eine Plattform des freien Wissens- und Meinungsaustauschs werden. Nicht vergessen sind aber die Zensurmassnahmen von Google bei Google Maps (Stichwort: Irak) und bei Google Search (Stichwort: China).

- Positionierung in den Google Suchresultaten – Entscheidend für Erfolg oder Misserfolg von Google Knols dürfte auch sein, wie die Inhalte in den Suchmaschinen auftauchen, insbesondere in der Google Search. Wikipedia-Artikel besetzen heute oft die Spitzenplätze in den Trefferlisten, was für die Akzeptanz der freien Enzyklopädie ganz entscheidend ist. Wird Google bei der eigenen Suche Google Knols in irgend einer Weise bevorzugen (z.B. so wie die Ergebnisse von Google News) und damit die eigenen Relevanzkriterien umgehen?

Eigentlich wäre die Idee, Mediengeschichte in Form eines Wikis zu erarbeiten, höchst spannend – besonders wenn es sich um eine nationale Institution wie das Schweizer Radio DRS handelt. Doch obwohl Radio DRS sowohl im Äther als auch auf der eigenen Website viele Möglichkeiten hätte, sein

Eigentlich wäre die Idee, Mediengeschichte in Form eines Wikis zu erarbeiten, höchst spannend – besonders wenn es sich um eine nationale Institution wie das Schweizer Radio DRS handelt. Doch obwohl Radio DRS sowohl im Äther als auch auf der eigenen Website viele Möglichkeiten hätte, sein